Configuración de red

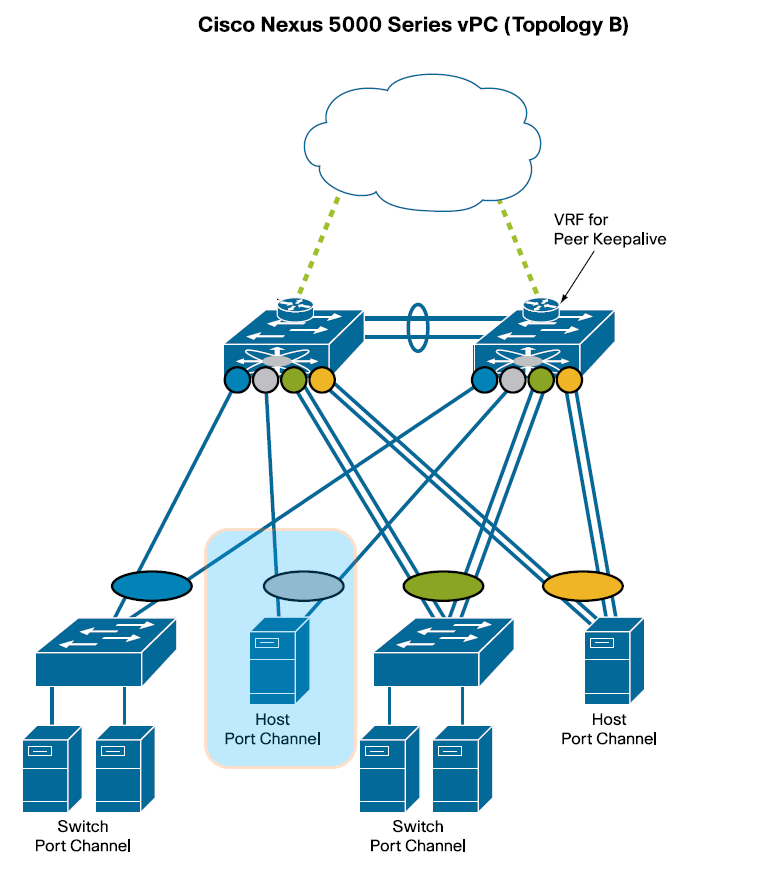

La red de datos que conecta los nodos del clúster es una red de alta velocidad en la que cada nodo dispone de dos NIC Ethernet agregadas (“bonded”) mediante LACP. Este enlace agregado proporciona el doble de ancho de banda y tolerancia a fallos, en caso de que uno de los enlaces individuales falle. Cada enlace individual estará conectado a sendos switches CISCO Nexus de la serie 5000 que componen un dominio vPC (virtual PortChannel). En la siguiente figura puede observarse esta estructura, destacada en azul, entre varias configuraciones típicas de conexionado vPC:

Para implementar el Host Port Channel en los servers se han de agregar mediante “bonding” las dos NIC estableciendo los siguientes parámetros:

- MODE= 802.3ad

- XMIT Hash Policy= layer2 (default)

- LACP rate= fast

Configuración switches vPC (virtual PortChannel)

Vamos a configurar la agregación de switches para nuestra red de alta velocidad. Tenga en cuenta que hay que realizar las configuraciones en los dos switches agregados (agg1 y agg2)

Los pasos a realizar son:

- Configuraciónes iniciales

|

1 2 3 4 |

agg1#configure terminal agg1#write erase agg1#reload agg1#skip |

|

1 2 3 4 |

agg1#username admin password agg1#hostname agg1 agg1#exit agg1#copy run start |

|

1 2 3 4 |

agg1#interface mgmt0 agg1#ip address 10.22.87.221/24 agg1#no shut agg1#copy run start |

- Habilitar características

|

1 2 |

agg1#feature vpc agg1#feature lacp |

- Configurar keep-alive en el puerto mgmt0

|

1 2 3 4 |

agg1#interface mgmt0 agg1#vrf member management agg1#exit agg1#ping 10.22.87.221 vrf management |

- Dominio vPC

|

1 2 3 4 5 6 7 8 |

agg1#vpc domain 10 agg1#role priority 100 agg1#peer-keepalive destination 10.22.87.222 source 10.22.87.221 vrf management agg1#peer-gateway agg1#auto-recovery agg1#ip arp synchronize agg1#ipv6 nd synchronize agg1#exit |

peer-keepalive han de intercambiarse para el switch agg2.

- Peer-link (el port-channel 15 será el peer link)

|

1 2 3 4 5 6 7 8 9 10 11 |

agg1#interface eth1/47-48 agg1#description **vPC Peer-link** agg1#channel-group 15 mode active agg1#no shut agg1#exit agg1#int port-channel 15 agg1#description **vPC Peer-link** agg1#no shut agg1#switchport agg1#switchport mode trunk agg1#vpc peer-link |

- Member ports

|

1 2 3 4 5 6 7 |

agg1# interface ethernet1/4 agg1# channel-group 4 mode active agg1# no shut agg1# interface port-channel 4 agg1# switchport agg1# vpc 4 agg1# no shut |

- Mostrar el resumen de configuración

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 |

agg1# show vpc brief Legend: (*) - local vPC is down, forwarding via vPC peer-link vPC domain id : 10 Peer status : peer adjacency formed ok vPC keep-alive status : peer is alive Configuration consistency status : success Per-vlan consistency status : success Type-2 consistency status : success vPC role : primary Number of vPCs configured : 5 Peer Gateway : Enabled Dual-active excluded VLANs : - Graceful Consistency Check : Enabled Auto-recovery status : Enabled, timer is off.(timeout = 240s) Delay-restore status : Timer is off.(timeout = 30s) Delay-restore SVI status : Timer is off.(timeout = 10s) Operational Layer3 Peer-router : Disabled Virtual-peerlink mode : Disabled vPC Peer-link status --------------------------------------------------------------------- id Port Status Active vlans -- ---- ------ ------------------------------------------------- 1 Po15 up 1 vPC status ---------------------------------------------------------------------------- Id Port Status Consistency Reason Active vlans -- ------------ ------ ----------- ------ --------------- 1 Po1 up success success 1 2 Po2 up success success 1 3 Po3 up success success 1 4 Po4 up success success 1 5 Po5 up success success 1 |

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 |

agg2# show vpc brief Legend: (*) - local vPC is down, forwarding via vPC peer-link vPC domain id : 10 Peer status : peer adjacency formed ok vPC keep-alive status : peer is alive Configuration consistency status : success Per-vlan consistency status : success Type-2 consistency status : success vPC role : secondary Number of vPCs configured : 5 Peer Gateway : Enabled Dual-active excluded VLANs : - Graceful Consistency Check : Enabled Auto-recovery status : Enabled, timer is off.(timeout = 240s) Delay-restore status : Timer is off.(timeout = 30s) Delay-restore SVI status : Timer is off.(timeout = 10s) Operational Layer3 Peer-router : Disabled Virtual-peerlink mode : Disabled vPC Peer-link status --------------------------------------------------------------------- id Port Status Active vlans -- ---- ------ ------------------------------------------------- 1 Po15 up 1 vPC status ---------------------------------------------------------------------------- Id Port Status Consistency Reason Active vlans -- ------------ ------ ----------- ------ --------------- 1 Po1 up success success 1 2 Po2 up success success 1 3 Po3 up success success 1 4 Po4 up success success 1 5 Po5 up success success 1 |