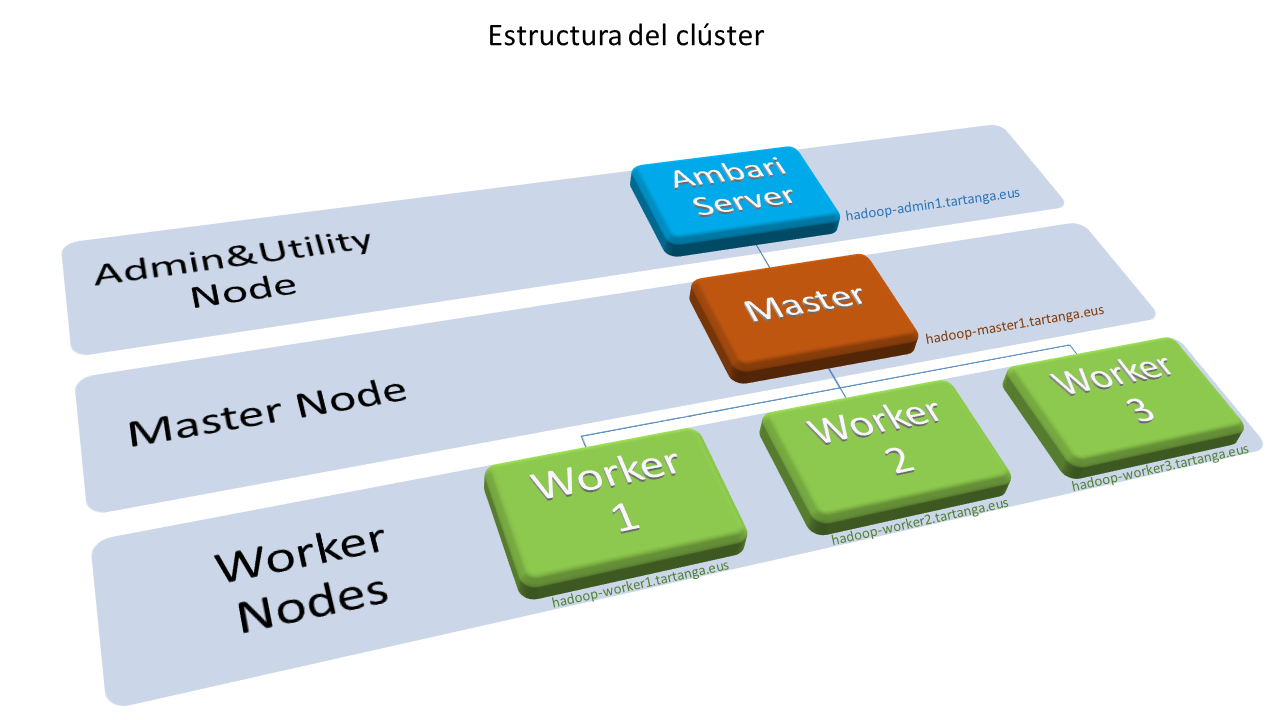

El nodo administrador tendrá la función fundamental de alojar el servidor Ambari que es la herramienta que vamos a utilizar para desplegar y, posteriormente, administrar y monitorizar el clúster. Tendrá menos requisitos de hardware ya que no ejecutará los servicios que forman parte de Hadoop. Lo utilizaremos también como nodo “frontera” para dar servicios adicionales de acceso al clúster.

Servidores

El servidor elegido para la implementación de este nodo es:

- Servidor DL380 Gen10 con chasis de 2U, con capacidad para 8 discos SFF, equipado cada uno con:

- 2 procesadores Intel Xeon Silver 4114 (10 cores, 2,20Ghz, 13,75 MB cache L3)

- 64GB de memoria RAM (8x32GB) DDR4

- Controladora de discos Smart Array P822 24xPCIe 8xSAS

- Adaptador ethernet de 4 puertos Gigabit integrado

- Tarjeta PCIe Ethernet de 2 puertos 10Gb/s SFP+ HP 530FLR

- Doble fuente de alimentación redundante de 800W

Discos

Discos duros 960GB SFF (2,5″)

- 2 discos SSD de 960GB SATA Read Intensive SFF

Configuración de almacenamiento

Los dos discos SSD se configurarán en RAID1 con dos particiones para el directorio raíz y el directorio de arranque:

A continuación puede observarse como han quedado las particiones, sistemas de archivo y su montaje después de la instalación:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 |

# lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT sda 8:0 0 894.3G 0 disk ├─sda1 8:1 0 1.1G 0 part └─sda2 8:2 0 893.2G 0 part └─md1 9:1 0 893.1G 0 raid1 ├─md1p1 259:0 0 1G 0 md /boot └─md1p2 259:1 0 892.1G 0 md / sdb 8:16 0 894.3G 0 disk ├─sdb1 8:17 0 1.1G 0 part /boot/efi └─sdb2 8:18 0 893.2G 0 part └─md1 9:1 0 893.1G 0 raid1 ├─md1p1 259:0 0 1G 0 md /boot └─md1p2 259:1 0 892.1G 0 md / |

Configuración de red

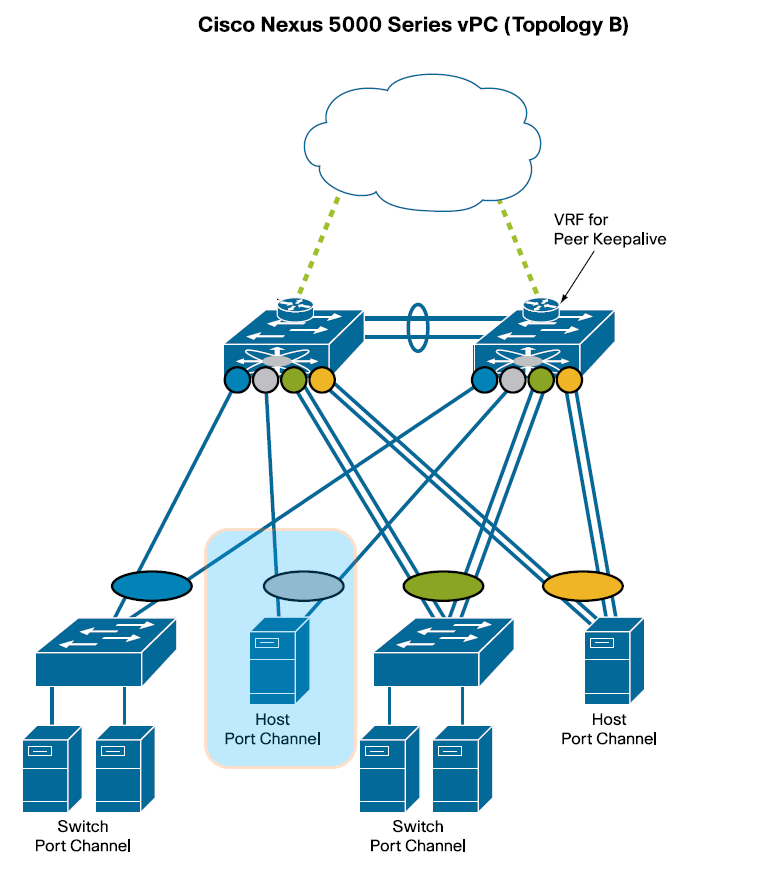

La red de datos que conecta los nodos del clúster es una red de alta velocidad en la que cada nodo dispone de dos NIC Ethernet agregadas (“bonded”) mediante LACP. Este enlace agregado proporciona el doble de ancho de banda y tolerancia a fallos, en caso de que uno de los enlaces individuales falle. Cada enlace individual estará conectado a sendos switches CISCO Nexus de la serie 3000 que componen un dominio vPC (virtual PortChannel). En la siguiente figura puede observarse esta estructura, destacada en azul, entre varias configuraciones típicas de conexionado vPC:

Para implementar el Host Port Channel en los servers se han de agregar mediante “bonding” las dos NIC estableciendo los siguientes parámetros:

- MODE= 802.3ad

- XMIT Hash Policy= layer2 (default)

- LACP rate= fast

El archivo de configuración de red queda como sigue:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 |

# cat /etc/netplan/01-bonding-config.yaml network: ethernets: eno1: dhcp4: false eno2: dhcp4: true eno3: dhcp4: true eno4: dhcp4: true eno5: dhcp4: false eno6: dhcp4: false bonds: bond0: interfaces: [eno5, eno6] addresses: [10.22.87.219/24] gateway4: 10.22.87.11 parameters: mode: 802.3ad transmit-hash-policy: layer2 lacp-rate: fast nameservers: addresses: - 10.22.87.1 - 8.8.8.8 search: - TartangaLH.eus version: 2 |